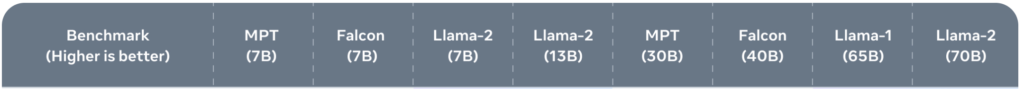

Parmi les nombreux benchmarks retenus pour comparer les performances de Llama 2 à ses concurrents, TriviaQA est le deuxième cité dans l’article de présentation du logiciel.

Note de Llama 2 / TriviaQA

La note obtenue par Llama 2 pour ce benchmark est de 85 pour la version 70B, ce qui le classe en 2ème position, juste derrière PaLM 2 (86,1) mais GPT-4 et ChatGPT n’ont pas été testés, seulement GPT-3 (71,2).

Description de TriviaQA

TriviaQA is a reading comprehension dataset containing over 650K question-answer-evidence triples. TriviaQA includes 95K question-answer pairs authored by trivia enthusiasts and independently gathered evidence documents, six per question on average, that provide high quality distant supervision for answering the questions.

https://nlp.cs.washington.edu/triviaqa/

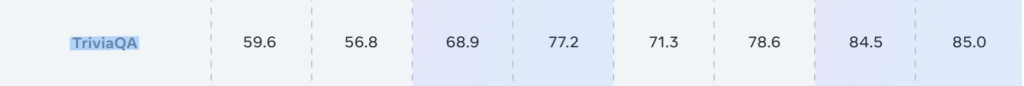

Classement de Llama 2 / ses concurrents

| Rank | Model | EM |

|---|---|---|

| 1 | PaLM 2-L | 86,1 |

| (one-shot) | ||

| 2 | LLaMA 2 70B | 85 |

| (one-shot) | ||

| 3 | PaLM 2-M | 81,7 |

| (one-shot) | ||

| 4 | PaLM-540B | 81,4 |

| (Few-Shot) | ||

| 5 | PaLM-540B | 81,4 |

| (One-Shot) | ||

| 6 | Codex + REPLUG LSR | 77,3 |

| (Few-Shot) | ||

| 7 | PaLM-540B | 76,9 |

| (Zero-Shot) | ||

| 8 | Codex + REPLUG | 76,8 |

| (Few-Shot) | ||

| 9 | GLaM 62B/64E | 75,8 |

| (One-shot) | ||

| 10 | GLaM 62B/64E | 75,8 |

| (Few-shot) | ||

| 11 | PaLM 2-S | 75,2 |

| (one-shot) | ||

| 12 | LLaMA 65B | 73 |

| (few-shot, k=64) | ||

| 13 | FiE+PAQ | 72,6 |

| 14 | LLaMA 65B | 72,6 |

| (few-shot, k=5) | ||

| 15 | FiD+Distil | 72,1 |

| 16 | LLaMA 65B | 71,6 |

| (one-shot) | ||

| 17 | EMDR2 | 71,4 |

| 18 | GLaM 62B/64E | 71,3 |

| (Zero-shot) | ||

| 19 | GPT-3 175B | 71,2 |

| (Few-Shot) | ||

| 20 | LLaMA 65B | 68,2 |

| (zero-shot) | ||

| 21 | Fusion-in-Decoder | 67,6 |

| (large) | ||

| 22 | MemoReader | 67,21 |

| 23 | S-Norm | 66,37 |

| 24 | TOME-2 | 65,8 |

| 25 | DPR | 56,8 |

| 26 | FLAN 137B zero-shot | 56,7 |

| 27 | RAG | 56,1 |

| 28 | Reading Twice for NLU | 50,56 |

| 29 | Mnemonic Reader | 46,94 |

| 30 | ORQA | 45 |

| 31 | MEMEN | 43,16 |